复习

- Devlin, J., Chang, M.-W., Lee, K., & Toutanova, K. (2018). Bert: Pre-training of deep bidirectional transformers for language understanding. arXiv Preprint arXiv:1810.04805.

复习

文档结构化是很暧昧的词, 它可能的意思很多, 不过本文只考虑目录抽取.

结构化文档由各级章节标题和段落等逻辑结构组成, 比如对 HTML 来说, 逻辑结构包括 <body> <h1> <p> 等标签. 文档结构化任务基本等价于目录抽取, 因为识别出标题后剩下的就是段落. 这个领域可供搜索的关键词包括 document structure recognition, document layout analysis (版面分析) 等. 意义: 便于抽取信息, 高度定制化的展示等.

复习

来自 Google 的

Consistency training methods simply regularize model predictions to be invariant to small noise applied to either input examples or hidden states. This framework makes sense intuitively because a good model should be robust to any small change in an input example or hidden states.

主要参考

一本只有 140 页的综述小册子. 本文主要基于第 5-6 章, 简要介绍图神经网络, 不涉及生成式 GNN 等内容.

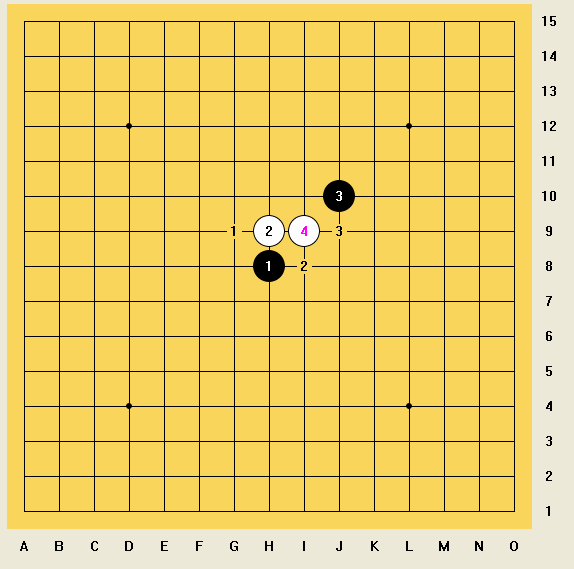

难得下一次棋, 水平没啥进步. 默认是五林上的对局.

最常见的是前三打: 一打偏黑, 二打平衡略偏白, 三打白小优 (结论出自 2021/9/13 漱星阁的索索夫规则开局指南). 分支太多了, 只看前几手.

参考 KataGo 和

棋谱的记号完全不明白.

由于历史遗留原因, 第一篇 Python 杂录 放在了 Language 类别下. 第二篇 Python 杂录更偏重 best practices.